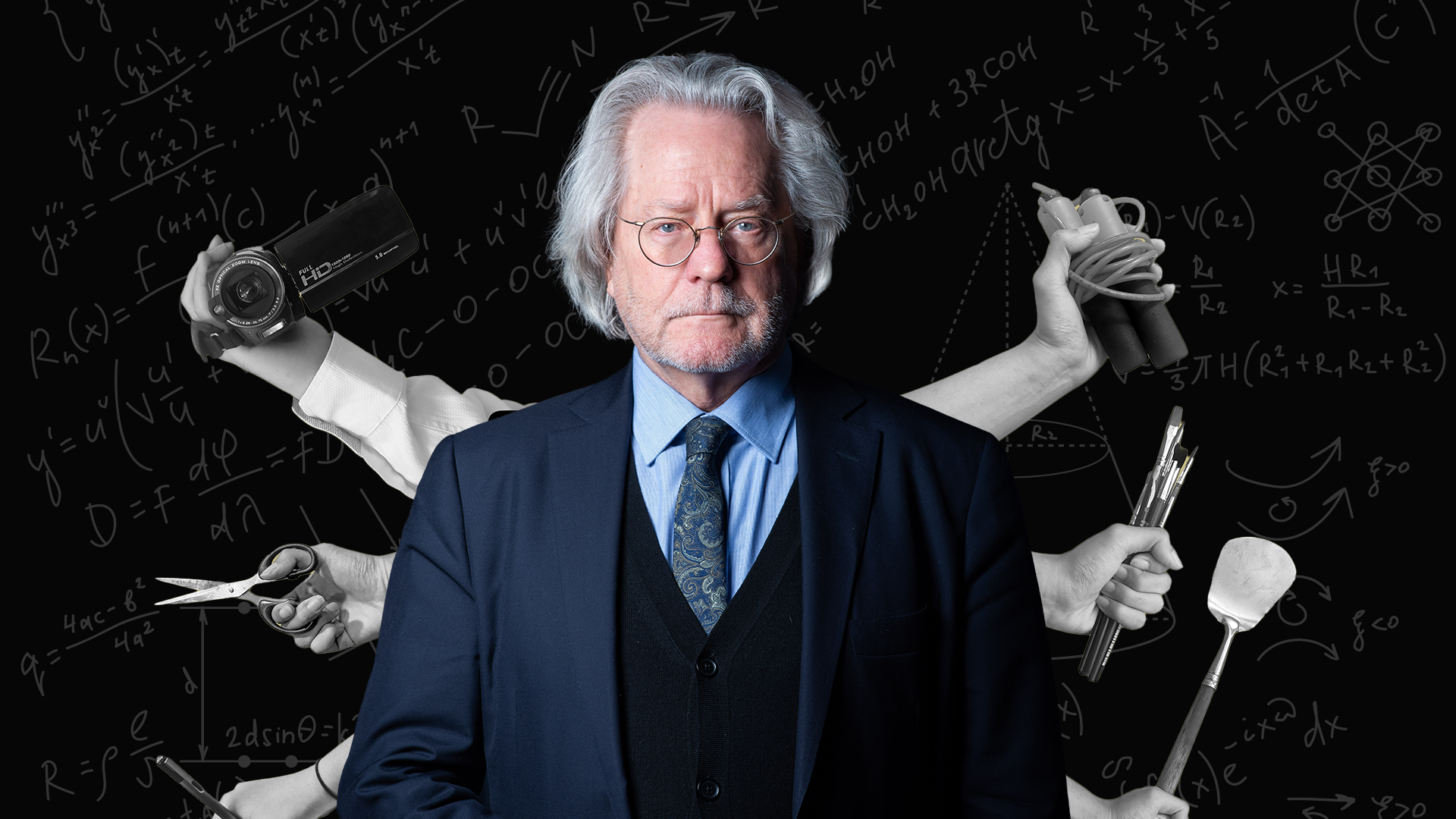

Gästforskaren: AI:n som person

Ett sätt att fundera kring vilka möjligheter en AI-entitet har att utveckla ett medvetande är att fråga sig huruvida det är möjligt för en AI-entitet att vara en person. Det skriver A.C. Grayling, veckans gästforskare.

Frågan väcker viss oro, bland annat eftersom ett normalkompetent och superintelligent väsen med långt större kunskap och kapacitet än inte bara varje enskild individ utan hela den samlade mänskligheten kan komma att svara just ”människor” på frågan om vilken den mest destruktiva kraften på jorden är, och följaktligen bestämma sig för att utrota henne på pragmatisk grund.

Men först några inledande satser: Entiteter som kan individualiseras är per definition subjekt (ett begrepp som kräver vissa predikat). Vissa typer av subjekt kan besitta ett ”jag” (i bemärkelsen varelser som i tillräcklig utsträckning är medvetna om sig själva som levande varelser, frånskilda andra varelser och ting). Vissa typer av jag kan vara personer, det vill säga agenter som besitter en hög grad av ansvarighet och som är medvetna, eller åtminstone har förmågan att utveckla medvetenhet, om hur de egna handlingarna påverkar andra jag och andra ting. Ett jag kan visserligen agera och vara medvetet om hur det egna jaget påverkas av handlingar, men är inte en agent såtillvida det inte är en person med förmåga att fatta informerade beslut. Oaktat determinism är det den personliga autonomin som är själva kärnan i all form av agens.

Vissa subjekt, alla jag, och tveklöst alla personer, ingår i samma moraliska universum.

I ett venndiagram hade ”vissa subjekt” utgjort en delgrupp i den bredare kategorin subjekt, ”alla jag” en delgrupp i ”vissa subjekt”, och ”alla personer” en delgrupp i ”alla jag”: överlappande cirklar som omsluter mindre cirklar.

Men, det finns även juridiska personer såsom företag, universitet, myndigheter och stater. En juridisk person besitter inte ett jag, vilket stökar till venndiagrammet en smula.

Det finns inga uppenbara skäl att begränsa det icke-juridiska begreppet person till myndiga, mänskliga individer. Kanske kvalar vissa högre primater in som personer enligt kriterierna ovan.

Om en AI vore i besittning av ett jag hade den ingått i samma moraliska universum som oss. Att stänga av en sådan entitet hade i någon mening inneburit att döda, kanske till och med mörda den.

”Att ingå i samma moraliska universum”: här krävs att vi fastställer ytterligare en sats. Ett moraliskt universum består av agenter och mottagare. Agenter är alla entiteter som kan vara medvetna om att deras handlingar påverkar såväl andra entiteter som de själva. Mottagare är alla entiteter som har en viss uppfattning om hur deras omgivning eller egna tillstånd påverkar dem, vare sig det är till deras fördel eller deras nackdel. Alla agenter är mottagare, men de flesta mottagare är inte agenter.

Kycklingar, laxar och rådjur är alla moraliska mottagare, men de är inte moraliska agenter.

En reservation: Eftersom moraliska mottagare innefattar allt som kan göra anspråk på moralisk betänklighet så är det en öppen fråga om huruvida ett träd är en moralisk mottagare eller ej. Om träd har en särskild uppfattning om positiv och negativ påverkan som drabbar dem, som vissa menar är fallet, så ingår de i vårt moraliska universum. Men det finns även andra argument som hävdar att träd ingår i vårt moraliska universum eftersom andra medlemmar i detta moraliska universum värdesätter deras existens och menar att påverkan på träden villkorar det värde som personer fäster vid det moraliska universumets gestalt. Om så är fallet så krävs det ytterligare en kategori: ”indirekta moraliska mottagare”. (Enligt min uppfattning är detta korrekt och rättfärdigar ekologism.)

Låt oss nu återgå till frågan om huruvida en AI-entitet kan vara en person, för även om så vore fallet hade det inte i sig varit tillräckligt för att förhindra människans förintelse. Det framgår av historien att personstatus nödvändigtvis inte tar hänsyn till det faktum att det finns andra moraliska mottagare, vare sig direkta eller indirekta, på bekostnad av egna intressen. Historien är snarare berättelsen om just den typen av underordningar. Här uppstår en av många märkliga frågeställningar: Är det moraliskt riktigt att förhindra uppkomsten av AI-entiteter kapabla till personstatus med anledning av den nyttokalkyl som diskuterades i det första stycket? (Skulle det vara som att säga att man hade mördat Hitlers mamma om man bara hade haft en viss klärvoajans?) Och om det handlar om att minimera risk på bekostnad av potentiellt enorma fördelar, är det då verkligen det förnuftiga beslutet att ta? (I backspegeln är det svårt att inta samma kontrafaktiska ställning gentemot Hitler, som att han till exempel inte skulle starta krig och begå folkmord utan i stället bli en stor konstnär.) Att bedöma risker för negativa utvecklingar längre fram är det bästa alternativet till efterklokhet: riskens omfattning är det som fäller utslaget i analysen av nyttokostnaden.

Men tänk om denna AI-person i stället skulle agera som ett välvilligt gudaväsen? Är det lika tänkbart som att den blir en iskall, kalkylerande utilitarist?

Ett övertygande argument som ibland lyfts fram är att alla självlärande AI-system bland sina grundvillkor borde utrustas med en uppsättning etiska bromsklossar (”skada inte människor”). Det finns dock ett problem med detta: Alla mänskliga individer är evolutionärt benägna till social anpassning, som är själva grunden till vår moraliska potential. Ändå blir vissa individer grymma. Socialisation (reds. anm. att individen internaliserar samhällets normer och värden) misslyckas tillräckligt ofta för att göra den här världen så pass svår som den trots allt är. En systeminställning är ingen garanti. Vad finns det som talar för att en AI kan utvecklas från sitt utgångsläge så att den vid ett hypotetiskt personblivande blir universellt god? Det, för att parafrasera Hamlet, är frågan.

Översättning av Michael Larsson.